云服务器和域名自动驾驶能“自己跑”?关键在看不见的GPU服务器

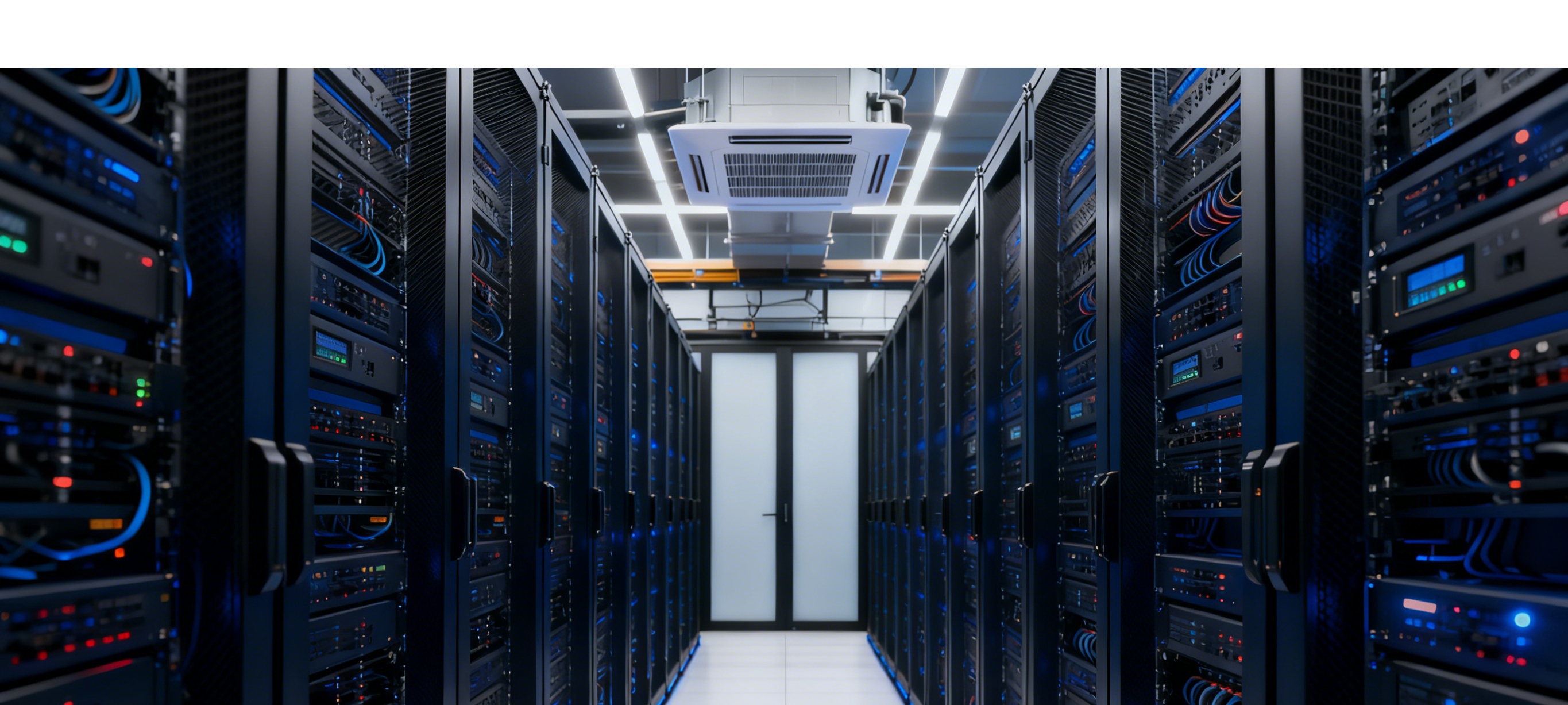

云服务器升级完成

当两款适配不同场景的 L3 级自动驾驶车型,在不同城市的指定路段开启试点时,多数人会关注车辆的最高车速、适用路段,却忽略了一个更关键的技术支撑 ——GPU 服务器。没有它,车载传感器收集的海量数据无法转化为 决策指令,自动驾驶的 智能 也就无从谈起。

一、车型场景差异:GPU 服务器 定制训练 的直接结果

两款车型的功能区别,本质是 GPU 服务器针对不同场景进行算法训练的产物:

适配拥堵场景的车型(最高车速 50km/h,适用城市快速路):要实现低速跟车、精准预判加塞,GPU 服务器需处理数百万组 短距离障碍物识别低速行驶姿态调整 的数据,通过反复训练,让算法能快速应对拥堵环境中的复杂工况,比如区分正常跟车与恶意加塞。适配高速场景的车型(最高车速 80km/h,适用机场联络线等高速路段):面对更快的车速变化,GPU 服务器的训练重点转向 远距离障碍物探测长距离行驶轨迹规划,确保算法能实时捕捉高速环境中的突发情况,比如提前识别前方车辆急刹。这种场景化的功能差异,完全依赖 GPU 服务器对算法模型的精细化训练,训练方向不同,最终呈现的车辆能力也不同。

二、L3 实现的三大关键:GPU 服务器的核心作用

阿里云服务器波动

云服务器接入 DBT

自动驾驶从 概念 到 落地,每一步都离不开 GPU 服务器的支撑,核心体现在三个层面:

算法模型的 超级训练基地:要让车辆具备识别红绿灯、避让行人、应对复杂路况的能力,需先向 GPU 服务器输入上亿组驾驶数据。以 拥堵场景加塞识别 为例,GPU 服务器通过并行计算能力,同时处理摄像头、雷达等多源设备传来的数据,快速筛选有效特征,将算法识别准确率从基础的 80% 提升至 99.9% 以上,这个过程若用普通计算设备,可能需要数月甚至更久,而 GPU 服务器能将时间压缩至数天。车云协同的 实时算力中枢:车辆行驶中,传感器会不断传回路况数据,GPU 服务器需瞬间完成数据融合与分析,构建高保真的环境模型。比如在高速场景中,它能精准识别 100 米外 15 厘米大小的障碍物,再将 减速避让 的决策指令传回车辆,整个过程延迟需控制在毫秒级,否则就可能错过最佳反应时机,这是车载芯片单独无法实现的算力支撑。自动驾驶能力的 持续进化引擎:L3 的能力不是固定不变的。车辆在试点中遇到的新场景(如特殊天气、复杂路口),会将数据实时传回 GPU 服务器。服务器利用这些新数据优化算法模型,再通过远程升级将优化后的模型推送至车辆,让自动驾驶能力不断迭代 —— 这种 数据反馈 - 模型优化 - 能力升级 的循环,核心动力就是 GPU 服务器。三、科研领域的 刚需工具:GPU 服务器的不可替代性

不仅是自动驾驶,在众多科研场景中,GPU 服务器也是不可或缺的核心设备,关键优势有三点:

算力密度碾压传统设备:以汽车风阻测试的流体动力学模拟为例,当模拟网格数每增加 10 倍,计算量会增长 100 倍。GPU 服务器凭借专用互联技术,能提供 300GB/s 的卡间带宽,轻松应对亿级网格计算,而普通设备可能需要数月才能完成,甚至因算力不足无法得出有效结果。大幅缩短科研周期:某科研团队用 GPU 服务器开展发动机燃烧模拟,2000 万网格的计算任务,耗时从 38 小时缩短至 6.2 小时;在气候建模领域,原本需要 3 个月的计算工作,借助 GPU 服务器 18 天就能完成。算力的提升,直接加速了科研成果从 理论 到 应用 的转化。适配全场景高算力需求:无论是自动驾驶算法训练,还是分子动力学模拟、天体物理研究、AI 医疗影像分析,GPU 服务器都能预装对应领域的专业软件,支持弹性显存配置。比如在新材料研发中,它能快速模拟原子运动轨迹,助力科研人员发现新的材料特性;在 AI 医疗领域,能高效处理海量医学影像数据,辅助提升疾病诊断准确率。云服务器升级完成

关键词:

扫码关注

微信好友

关注抖音