查看云服务器带宽火山云GPU服务器在PyTorch分布式训练中如何实现高效的模型并行?

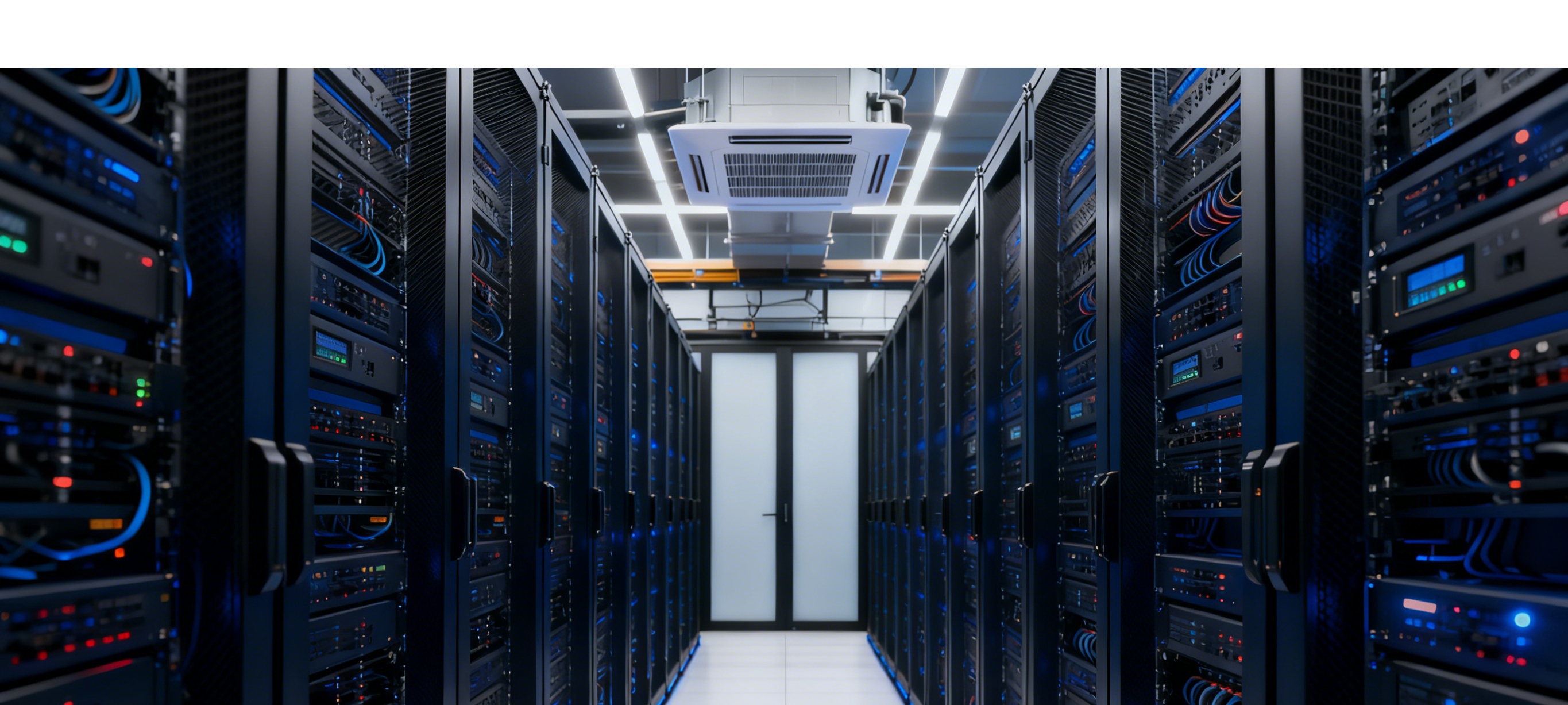

网站存放 云服务器

火山云GPU服务器在PyTorch分布式训练中实现高效的模型并行主要通过以下核心技术架构和优化策略:

核心技术架构

1. 全栈自研虚拟化技术

火山云采用自研DPU(数据处理器)实现虚拟化0损耗,通过自研虚拟化组件和虚拟交换机BVS搭配定制处理器,彻底突破传统软转性能天花板。这种架构使得GPU云服务器能够释放超强算力和极致IO性能,网络延迟低至20us,包转发率达到5000万PPS。

2. 高性能网络互联

火山云采用RDMA(远程直接内存访问)技术和100Gbps低延迟网络,相比传统TCP/IP网络可降低80%的通信延迟。通过自研的VPC网络拓扑优化算法自动选择最短传输路径,确保多机多卡场景下的高效通信。

模型并行实现机制

1. 分布式数据并行(DDP)

火山云深度集成PyTorch的DistributedDataParallel模块,采用多进程对等通信架构。每个GPU对应一个独立进程,通过NCCL后端进行高效通信,支持单机多卡和多机多卡训练。核心实现流程:

初始化进程组:使用torch.distributed.init_process_group(backend=nccl)建立通信环境模型包装:model = DDP(model, device_ids=[rank])自动处理梯度同步数据切分:使用DistributedSampler确保每个进程获得不重叠的数据子集2. 混合并行策略

火山云支持数据并行、模型并行和流水线并行的混合策略,特别针对千亿参数模型训练效率提升40%。通过自研的veGiantModel框架,支持根据参数量和计算量自动切分流水线。

深圳云主机云服务器

通信优化技术

1. 智能通信优化套件

火山云提供三大核心通信优化组件:

梯度压缩算法库:支持1-bit量化、Top-K稀疏化等技术,减少90%通信数据量AllReduce优化器:动态选择Ring/Tree算法,比原生NCCL提升15%效率通信-计算流水线:重叠通信与计算时间,消除等待空闲2. 梯度同步优化

通过分桶(Bucketing)技术将梯度打包进25MB的Bucket中,避免频繁发送小包导致网络拥塞。当Bucket填满时触发一次All-Reduce操作,显著提升通信效率。

甘肃临夏云服务器

性能表现

1. 训练效率提升

在ResNet152分布式训练测试中,火山云方案将通信耗时占比从常规云服务器的32%降低至8%,训练吞吐量在A100×8卡场景下从420 images/sec提升至580 images/sec。

2. 扩展性表现

火山云支持千卡级分布式训练,采用自研MLU芯片+光互联拓扑,ResNet-50训练时间缩短至11分钟。在8卡训练场景下,效率可达单卡的7.2倍(ResNet50基准测试)。

成本优化策略

1. 弹性资源调度

火山云支持秒级启动千卡集群,训练任务可自动扩缩容,支持按需/预留实例混合部署,资源利用率提升60%以上。通过竞价实例模式,容错型任务成本可降低90%。

2. 潮汐复用技术

百万台量级服务器与抖音等业务内外分时潮汐复用,当抖音业务算力资源闲置时,闲置资源流转给企业客户,显著降低客户上云成本。

开发体验优化

1. 预装AI工具链

火山云提供预装CUDA 11.6和PyTorch 1.13的官方镜像,5分钟内完成环境初始化。支持PyTorch、TensorFlow等主流框架的深度优化镜像,开箱即用,无需额外适配。

2. 一站式管理平台

通过火山引擎控制台,用户可以轻松监控GPU资源使用情况、任务调度状态,并快速定位性能问题。提供自动化建模平台和超参优化引擎,调参效率提升5-8倍。 火山云GPU服务器通过其全栈自研技术架构、智能通信优化和丰富的生态工具链,为PyTorch分布式训练提供了行业领先的模型并行解决方案,特别适合大规模AI模型训练和推理场景。

香港服务器星辰云

扫码关注

微信好友

关注抖音