美国服务器大带宽美国最强学术超算Horizon开始安装,配备英伟达新型服务器

美国vps带宽

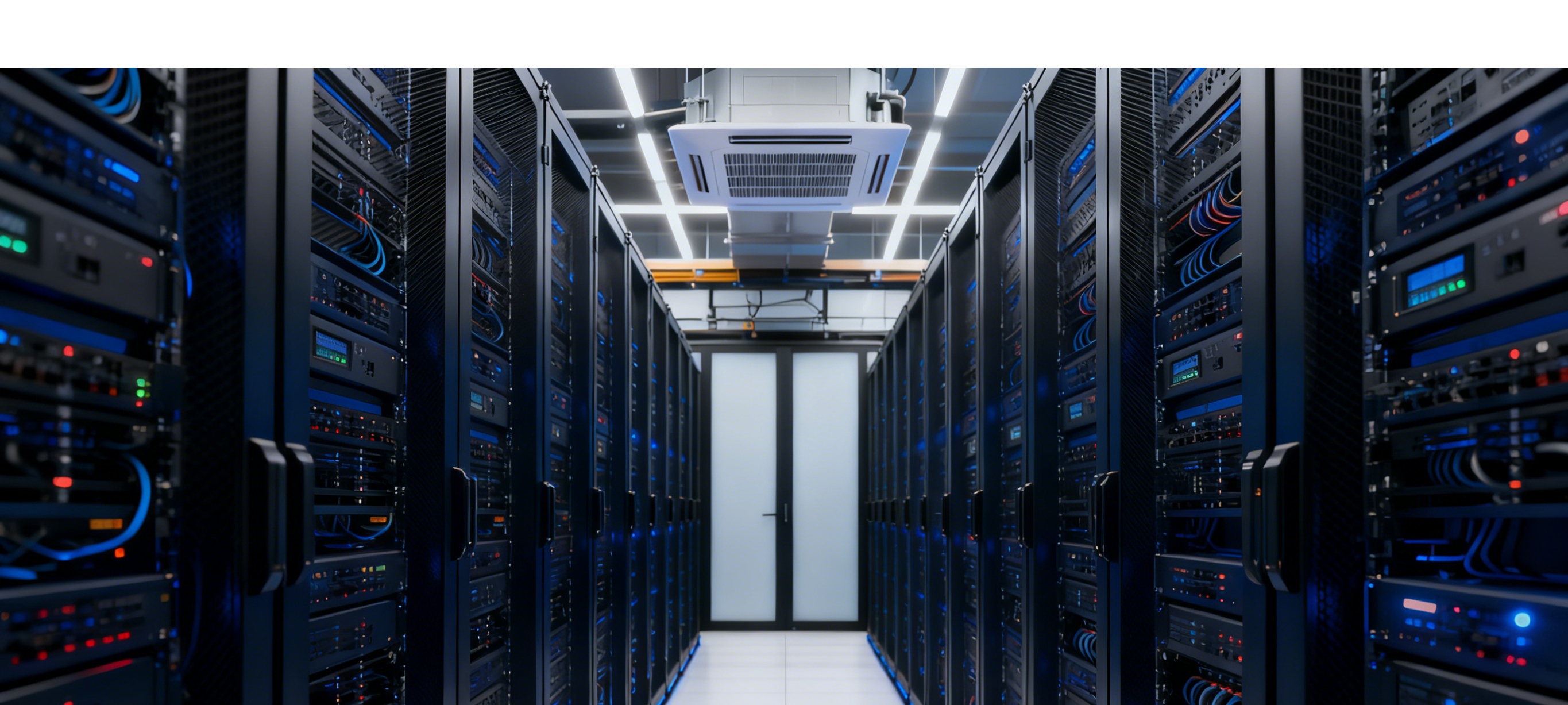

安装那天是11月17日,地点在得克萨斯大学奥斯汀分校的高性能计算中心,负责这次工程的是美国国家科学基金会。工作人员把一箱箱设备推进数据机房,从机架到线缆、从散热管道到电源,都要一件件就位。现场不是一气呵成的活,动作有条不紊:先把服务器和加速卡装进机架,再接网络和存储,之后通电做自检,最后跑几轮基线测试确认没问题。像组装一辆复杂的汽车,每个螺丝、每根线都不能马虎。

这次装机的团队来自好几家厂商,分工很明确。有人专门负责计算节点的调试,有人盯着网络和互连交换机,有人负责检查能耗和冷却系统。大家像流水线上的工人,各司其职,但每一步都得掂量轻重,出现故障的成本不低。现场的气氛既紧张又有点平静——每个人都在做最稳妥的那一套事儿。

技术配置上,Horizon 不是简单把现有机器堆起来。它用的是英伟达的 Grace Blackwell 芯片作为重要的计算单元,同时还有基于 Vera 架构的 CPU 服务器来处理通用计算。整机规模很大:大约有一百万个 CPU 核心,配套约 4000 块 GPU。网络层面采用英伟达的 Quantum-2 InfiniBand,保证节点之间的数据传输能跟得上这些算力。存储方面配备了约 400PB 的全闪存阵列,读写延迟和吞吐量都很高,专门为大规模模拟和 AI 训练准备的。

看指标会让人眼花缭乱:在传统的双精度浮点运算(FP64)下,峰值能到 300 petaflops。放到学术用途的超算里,这是顶尖水平,和目前学术界一些系统比起来是明显领先的。AI 计算方面更夸张:如果用 BF16 或 FP16 这类半精度格式,系统峰值能到约 20 exaflops;用更低精度 FP4,理论峰值甚至能到 80 exaflops。厂方说跟现有设备比,AI 算力提升超过百倍。读着这些数字,直观上就是一串漂亮的参数,但把它变成稳定、可重复的生产力,得靠软硬件和调度系统三方面合力。

散热是大问题,Horizon 选择了液冷方案。液冷和传统风冷比起来,去热效率明显好,能把芯片产生的热量直接带走,散热路径短,能耗损失也少。官方说机组能效比现有方案提升大约六倍。这对运行成本影响很大,但机房得配套更复杂的冷却基础设施——要提前铺设冷却回路、备用电源,现场准备工作因此更繁琐。想想就知道,水路、电路、一点小问题都可能影响整套系统的稳定运行。

这项目是由美国国家科学基金会发起,目的明确:给学术界提供一个能支撑下一代科学研究、工程模拟和 AI 开发的共享算力平台。TACC(得克萨斯先进计算中心)是承载单位,负责机房改造、电力升级、冷链配置和后续运维规划。硬件采购和集成由多家厂商合作,大家负责不同模块,最后由 TACC 统一验收并试运行。说白了,这不是某一家公司的秀场,而是一个需要多方配合的大工程。

时间表上,装机会在今年年底持续推进,接下来要完成网络互连测试、系统级调优、用户访问策略和安全防护验证。到明年春季之前,TACC 会分阶段开放一部分节点给科研团队做小规模试验,等整体稳定后再全面放开。这个步骤很关键,因为在这么大规模的系统上,很多问题只有在真实工作负载下才会暴露出来。厂商可以在实验室里跑测试,但千万别指望那和真实用户的长期负载完全一样。

对学术用户来说,Horizon 到来意味着能跑更大规模的物理模拟、气候模型、基因组分析、材料计算,以及更大规模的深度学习训练。现在很多研究被算力和数据吞吐限制住,不得不在模型规模和精度上妥协。有了更强的算力,能去试以前没法碰的问题。不过,把模型直接丢进机器也不见得就能跑得好,这就涉及软件适配问题:代码要能高效利用 GPU、CPU 和高速互联,编译器、库和调度器都要优化好。

这方面的工作不会一夜之间完成。要开发适配库、优化编译器、调整调度策略,甚至改写算法的某些部分,让科学计算框架能顺畅地在这套硬件上跑。换句话说,硬件到位只是第一步,软件层面的改造同样重要。很多团队在临时搭建模型时会遇到瓶颈,比如通信延迟、内存带宽限制、I/O 成为瓶颈等问题,这些都得在部署前后逐一攻关。

美国专线服务器

运维方面的细节也不少。机房的电力负荷要规划好,供电系统得稳定并留有冗余;网络布线和交换节点布局要避开瓶颈,尤其是远程内存访问和同步操作时的延迟问题;存储系统要能同时应对大量小文件操作和大块数据的混合访问;监控体系得尽早搭建,实时跟踪温度、电流、错误日志等关键指标。处理不好,这套系统的可用性和寿命都会受影响。实务上,很多问题都是细节决定成败。

从更大的角度看,这次部署也是现代超算如何进化的一个缩影。现在的超算不是单纯拼算力,还是硬件、网络、存储和冷却多方面协同的工程。Grace Blackwell 这种面向 AI 的加速器和传统 CPU 协同工作,再配上高速的 InfiniBand 网络和大容量固态存储,才能在实际任务中带来性能跨越。表面上像是在堆数字,但每个环节都得落到实处,否则这些高大的指标就只是纸上谈兵。

现场的人都知道,从安装到稳定运行需要多轮迭代。先把硬件装进去、线连好,然后把基础软件栈搭起来做压力测试,接着邀请早期用户来试跑真实作业,收集问题并修复。这个过程中常见的问题包括配件延迟、兼容性差异、散热调校不到位等。TACC 的团队必须和厂商保持紧密沟通,把日志和诊断数据及时共享,方便快速定位问题并修补漏洞。

资源分配和用户管理也要提前想明白。像这种共享型学术超算,既要支持大型长期项目,也要照顾到中小团队和教学用途。调度器要做到既公平又高效,存储配额、作业优先级和网络隔离等策略都要明确。这些制度性东西影响科研产出效率,运维团队在制定规则时需要综合考虑学术公平性和资源利用率。

此外,安全和合规也不能忽视。共享平台上运行大量敏感科研数据,访问控制、数据隔离和备份策略要到位。TACC 在开放节点前会做安全验证,确保只有通过认证的科研团队能使用特定资源,防止数据泄露或滥用。再加上硬件层面的物理安全,整体防护必须成体系。

装机之后的几个月将是关键期。设备要通过连通性测试、系统级调优和早期用户的压力试验。到 2026 年春季正式投入服务后,大家会看到这套机器能做什么、在哪些领域有明显突破。你如果关心自己的项目能不能上机,最实际的做法是关注 TACC 的后续通告,留意用户测试计划和节点开放清单,按步骤申请。不要等到大家都开始申请时才慌忙准备,提前准备好代码和测试用例更容易抢到资源。

在现实操作层面,研究团队也要提前做好准备:把代码改成能混合使用 GPU 和 CPU,尽量减少 I/O 瓶颈,做好并行化处理的检查。很多科研团队在初次上大型超算时会被一堆奇怪的错误绊住脚,常见的就是并行通信出错或内存越界。提前做小规模测试,逐步扩大规模,会比直接一次性全量提交要稳妥得多。

眼下公开的信息显示,装机工作已经动手,未来几个月会非常忙碌。等到系统稳定,Horizon 会成为学术界新的计算平台,接下来就是看软硬件能不能配合好、运营细节是否到位。这些亮眼的数字要落地,得靠一群人在幕后把所有细节都捋顺。若你是潜在用户,别急着盯着什么时候能跑完,先把你的代码、数据和提交流程准备好,等 TACC 放出节点清单再去申请。

美国硅谷服务器

扫码关注

微信好友

关注抖音