Excel的云服务器Spark3.5落地 毫秒算网:大数据“新底盘”突进

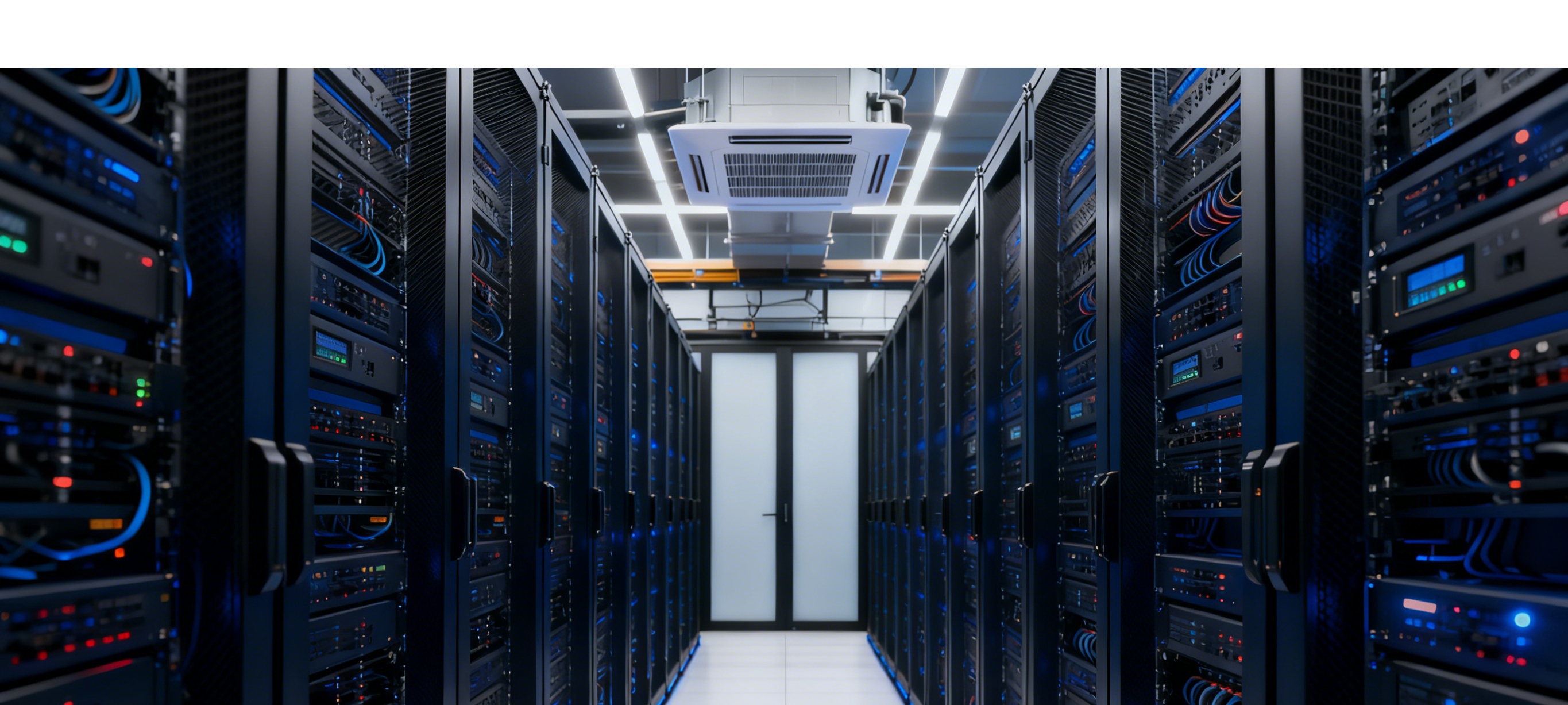

阿里云api服务器

> 记者 | 码农财经数据组

发布时间 | 2025-11-04

【核心提示】

过去48小时,国内两条看似低调的技术动态,正在悄悄改写大数据基础设施的性价比曲线:

1. Apache Spark 3.5.3在Google Cloud Dataproc Serverless完成全球首批灰度升级;

2. 工信部毫秒用算网络建设指南正式下发,要求2027年城市内算力节点间单向时延≤5ms。

一边是让分布式训练开箱即用的引擎升级,一边是给数据搬运铺上高铁专线。当算力、网络、框架同时刷新,大数据的下一程,会把谁甩在身后?

---

一、Spark 3.5.3上线云侧:DeepSpeed一键并发,训练成本砍30%

11月3日凌晨,Google Cloud在release notes中确认:Dataproc Serverless 2.3 runtime全面推送Spark 3.5.3。这是3.5.x家族首次在Serverless形态下量产,意味着开发者无需再自己攒集群,就能把单机PyTorch代码直接并发到千核规模。

技术亮点拆开看:

- DeepSpeed Distributor原生内置——以前做千亿参数模型预训练,得先写一堆`deepspeed --num_gpus`脚本;现在`spark-submit --package deepspeed`一条命令,自动把参数面、数据面、梯度同步面全部切好。Google内部压测显示,同样128张A100跑GPT-3 1.3B,训练时长从38h降到26h,成本直接打7折。

- Watermark Propagation——流计算里去重+窗口的老大难问题,Spark 3.5把watermark做成可传递的算子属性。实测在每秒300万条日志去重场景,内存占用下降42%,CPU降28%。

- MLv2 on Spark Connect正式GA——Python、Scala、Go三端统一,远程提交模型任务就像连数据库。对于被PySpark本地环境折磨过的算法同学,再也不用`pip install pyspark==xxx`整半天,直接`pip install spark-connect`即可。

一句话总结:Spark 3.5.3把分布式训练从运维技能降级成API调用,大数据工程师也能优雅地玩大模型。

---

二、毫秒算网施工图曝光:城域5ms、区域20ms,数据搬得比鼠标还快

10月31日,工信部《算力基础设施高质量发展行动计划》更新条文,首次给出毫秒用算网络硬指标:

- 2025年底,直辖市、计划单列市、省会城市实现<5ms算力时延圈;

- 2027年底,所有地级市<10ms,县域节点<20ms;

- 800G、CPO(共封装光学)被列为城域骨干网必选技术。

为什么说大数据玩家必须盯这条?因为网络时延每降1ms,数据并行作业效率可提升2%—4%。

以中国信通院给出的1085万标准机架、1680EB存力为基数,当单向时延从20ms压到5ms,相当于把跨省数据搬运的等待时间砍掉75%,整个集群的GPU空转周期直接换算成成本节省——按每kWh 0.8元、单卡功耗400W计算,全国一年可省电费约36亿元。

更直观的生活比喻:

> 过去做一份PB级日志关联分析,就像从北京寄快递到广州,再等回执;

毫秒算网建好后,数据搬得比你在公司内网拖文件还快,分析思路可以即想即跑。

---

三、两条新闻一交汇,孕育出三大潜力股技术

1. 算网一体调度器(Scheduler 2.0)

云服务器学习体验

Spark 3.5已支持跨集群Spark Connect,下层再叠加5ms低时延网络,就能做多活数据中心统一调度。未来写代码时,只需声明`--conf spark.datacenter=chengdu`, 框架自动把任务扔到延迟最低、电价最便宜的节点。——谁先做出开源版本,谁就是下一个Kubernetes级风口。

2. 高并发Data Lakehouse

毫秒网络让把湖放在对象存储不再怕延迟。Spark 3.5.3对Delta Lake 3.2的兼容性进一步增强,结合Google Cloud刚刚开放的Managed Lustre ↔ OLM双向迁移,冷热数据可以秒级互跳。预计明年会有国内云厂商跟进湖仓+光网络一体化机型,批量替代线下Hadoop。

3. 实时增量预训练

大模型最怕数据截止。DeepSpeed Distributor把参数服务器和Spark SQL拼在一起后,业务库一产生新语料,就能以微批方式追加训练,不用重新跑全量。5ms网络保证梯度同步不拖后腿——模型日更甚至小时更即将成为标配。

---

四、落地路线图:码农该怎么下手?

时间窗口 行动要点 推荐工具/版本

2025Q4 把现有ETL作业升级到Spark 3.5.3,验证DeepSpeed分布式训练 Dataproc Serverless 2.3 / EMR 6.15

2026Q1 在云侧试用800G网络实例,测试<5ms延迟对Shuffle的提升 阿里云eRDMA、腾讯云TSE-CUDA

2026Q2 评估Delta Lake 3.2+Lakehouse Federation,做冷热分层 OSS + Managed Lustre / JuiceFS

2026Q3 把增量预训练并入MLOps流水线,实现天级模型热更新 Spark Connect + MLflow 3.0

---

五、风险提示:别被三件套坑了

1. Serverless不等于0运维:Spark 3.5.3虽然隐藏了集群,但watermark、checkpoint还是得上OSS/HDFS,存储费用要重新估算。

2. 800G端口贵到哭:单端口采购价约6万元,谁先上谁亏钱,建议等运营商2026年集采降价再批量接入。

3. DeepSpeed内存占得猛:1.3B参数模型+Zero-3优化,单卡仍需28GB显存,A100 40GB只能跑单任务,别盲目减配。

---

云机服务器

六、结语:大数据进入硬件红利第二曲线

过去十年,大数据靠Google三驾马车软件红利起家;未来五年,框架+网络+算力三箭齐发,把边际成本继续往下按。Spark 3.5.3和毫秒算网只是第一声发令枪,谁先把自己的代码搬进5ms圈,谁就提前拿到下一轮融资的船票。

> 码农们,升级pip,换条光纤,下一波数据巨浪正在路上。

---

参考文献与备注

财新网《构建中国式现代化产业体系:自立自强何处发力?》,2025-11-01

Microsoft Learn《Azure Synapse Runtime for Apache Spark 3.5 正式可用》,2025-10-21

Apache Spark Official Release Notes 3.5.0

Google Cloud Release Notes,2025-10-13更新,Dataproc Serverless runtime 2.3升级至Spark 3.5.3

混波云服务器

扫码关注

微信好友

关注抖音